ニュース

AR-HUD – 言葉なしで対話するテクノロジー【コンチネンタル・オートモーティブ】

2014年7月21日

● 異なる再生プロセスをもった2つの画像生成ユニットの光学システムは、拡張現実ヘッドアップディスプレイ(AR-HUD)で相互補完

● 新しいARクリエイターにおけるグラフィック生成には複雑なプロセス

● eHoriozonによる情報は将来のドライバー情報の基礎に

新しい形式の車とドライバー間の対話を可能にするため、国際的な自動車部品サプライヤーであるコンティネンタルは、拡張現実ヘッドアップディスプレイ(AR-HUD)を開発しました。この表示システムでは交通状況が、ドライバーが見る通りにディスプレイシステムに拡張されます。光学的映像により極めて正確に車外ビュー上に表示されるグラフィック情報が、交通状況に直接埋め込まれます。AR-HUDは、車におけるヒューマン・マシン・インターフェイス(HMI)における最も革新的な進歩と言えるでしょう。

コンティネンタルにとって、この技術革新は長い歴史をもっています。コンティネンタルの計器&ドライバーHMI事業部の責任者であるエルコ・スポエルダー(Eelco Spoelder)は「過去110年以上にわたり、できる限り最高のドライバー情報を提供してまいりました。タコメーターに始まり、各種異なる自動車向けの表示および制御ソリューションの主導的開発者に発展しました」と述べています。「今日のHUDテクノロジーは、1902年の渦電流タコメーターに匹敵し、すなわちドライバーのための基本的な補助機能です。AR-HUDは、大いにこれに当てはまります。」

AR-HUD技術は、大量生産前の段階に到達しました。デモンストレーション車は、実現可能性を実証するために使われる一方、シリーズ開発のために価値ある情報を提供してくれます。コンティネンタルでは、2017年に大量生産準備が完了する予定です。

AR-HUD : 見ることは理解すること

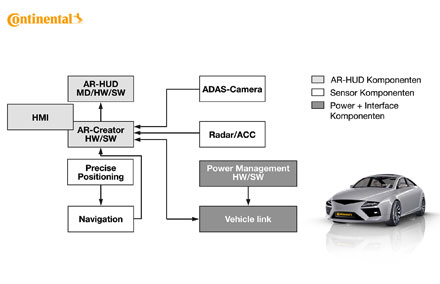

「AR-HUDの光学システムは、ドライバーに、運転者支援システムがどのような状況か、その情報にどのような意味があるかを拡張し、直接ドライバーの視野に提示します」と、コンティネンタルのインテリア部門でHUD技術エキスパートのパブロ・リヒター(Dr. Pablo Richter) は説明します。「ヒューマン・マシン・インターフェイスの新しい分野として、今日のパイロット生産段階にあるAR-HUDは、運転者支援システムの環境センサー、GPSデータ、地図資料、車両ダイナミクスデータと密接に連結しています。」

コンティネンタルは、デモンストレーション車に、先行開発段階の新技術を初めて実装しました。選ばれた車両にはレーダーセンサーが前バンパーの後ろに、CMOSモノカメラがバックミラーの土台に組込まれています。AR-HUDのためアプリケーションに関連して選ばれた先進ドライバー・ アシスタンス・システム(ADAS) 機能には、車線逸脱警報 (LDW)、アダプティブ・クルーズ・コントロール(ACC)があり、それらに加えナビゲーションシステムのルート情報機能も利用可能です。

さらに、リヒターは「運転者支援システムのどれかひとつに関わる状況を認識すると、AR-HUDにおける仮想グラフィックによる指示がドライバーに注意を喚起します」と説明します。「安全性の向上とともに、この対話形式は自動運転の主要技術となります。この拡張により、ハンドルを握る人が運転の新機能に簡単に信頼を築けるようになります。」

明らかに異なる映写距離を持つ2つの画像レベル は、2つの異なる画像生成ユニットに基づく

新しいAR-HUDでは、2つの画像レベルが異なる映写距離で実現されており、ニアレベル又はステータスレベル、そしてリモートレベル又は拡張レベルと呼ばれます。ニアレベルの場合、ドライバーの前方、ボンネットの端に浮かんで見え、ドライバーに選択されたステータス情報、例えば車速、追い越し禁止や速度制限のようなルート制限適用事項、アダプティブ・クルーズ・コントロール(ACC) の設定内容などの情報を提供します。ドライバーはわずか6度ほど視線を下げるだけで、これらの情報を読み取ることが可能です。ステータス情報は、2.4 m の映像距離で サイズ 5°x1°(210 mm x 42 mm に相当)の視界に現れます。これは「典型的な」ヘッドアップディスプレイの仮想画像に相当し、ミラー光学と画像生成ユニット(PGU)に基づいています。後者は薄膜トランジスタ (TFT)ディスプレイから成り、その内容はLEDでバックライトされます。このユニットは極めてコンパクトにAR-HUDモジュールの上部に組込まれています。ミラー光学において、ディスプレイの内容は仮想表示のために拡大されていますが、これは曲面ミラーを用いて実現されます。AR-HUDにおいて異なる映像距離にある2つの画像レベルを実現するため、コンティネンタルは巧みに選択した光学デザインを用いています。ここで両レベルのそれぞれの光路は内部でわずかにオーバーレイします。近くのレベルの光路は、他のいわゆる折りたたみミラーなしに、大きなAR-HUDミラー(大きな非球面)の上部末端だけを利用し、AR-HUDシステムのこの部分は、現在コンティネンタルの第2世代HUDとしてシリーズ車に組込みこまれている技術レベルに一致しています。

映画技術による車での拡張

リヒタ―は「AR-HUDにおいて主要な役割を果たしているのはもちろん拡張レベルです。これはドライバーの前7.5m の映像距離に、拡張されたイメージを表示シンボルによって道路に直接提供します。その内容は現在の交通状況に対応しています。」と述べています。このリモートレベルの内容は、フランクフルトモーターショーIAA2013で初めて発表した、新しい画像作成のユニットにより生成されます。デジタル映画プロジェクターと同様、グラフィックのエレメントはデジタル・マイクロ・ミラーデバイス(DMD)を用いて生成されます。PGUのコアは光学セミコンダクターと静電気フィールドを用いて個別に傾けることが可能な、数十万もの小さなミラーからなるマトリックスで形成されています。マイクロミラーマトリックスは逐次時系列で交互に3色のLED (赤、青、緑) が点灯します。その際3色の光の光学視準 (平行方向) は、カラーフィルター機能のある偏向ミラー(いわゆるダイクロイックミラー) によって行われます。この特殊なミラーは色に応じて光を通したり反射させたりでき、この色のすべてのマイクロミラーは、いま点灯している色とタイミングを同期して入射光をレンズを通して反映するように傾斜し、この色の個々のピクセルとして後続のフォーカシングスクリーンに表示されます。これは3色すべて同時に起こります。人間の目は3色すべてをフォーカシングスクリーン上で「平均化」するので、フルカラーの印象になります。

フォーカシングスクリーンの正面から見ると、それに続く光路は従来のHUDに対応し、最初のミラー(折り返しミラー)を経由して、フォーカシングスクリーンの画像は2番目の大きなミラー (AR-HUDミラー)に反映され、そこからフロントガラスへ映写されます。拡張のための光学システムの射出面はほぼDIN A4サイズです。これにより拡張レベルにサイズ10°x4.8°の視界が生じます。これは幾何学的に、直接的視野において拡張可能な視覚表面、幅130 cm、高さ63 cm に相当します。このリモートレベルでの情報は、ドライバーの視線を2.4度ほど下げることで読み取ることが可能です。ステータスレベル及び拡張レベルの画像生成ユニットは、周囲の明るさに適応した1平方メートル当たり10,000カンデラ以上の光度で、表示が可能であり、周囲の明るさがどんな条件でも表示を読み取ることが可能です。

コンティネンタルのテスト車のシステムアプローチは異なる映写距離で2つの画像レベルを持つため、大きな利点を持っています。たいていの交通状況において、内容はリモートレベル、ニアレベルに同時に実行でき、関連する運転情報や状況に関する情報がドライバーの直接の視界内に表示されます。

ARクリエイターでのデータ統合とグラフィック生成

多数のシミュレーションやコンティネンタル独自の被験者実験において、拡張が車の18~20m位先で始まり、道路コースに応じて約100 m 離れるまで継続されれば、ドライバーにとって快適であることがわかりました。ARクリエイターの開発責任者ペーター・ギーゲリヒ(Peter Giegerich)は、これらグラフィックの指示がどのように生成され、適切に設置されるかを説明しています。「ARクリエイターは非常に高機能な新開発です。制御装置は、グラフィックエレメントがドライバーのAR-HUD視野に極めて正確に映し出されるフォーカシングスクリーン上に、グラフィックエレメントを正確に配置するため、多数のセンサーデータストリームを分析しなければなりません。そこでは計算の技法が若干必要とされます。」

ARクリエイターは3つの情報源からデータ統合を引き受けます。道路コースの形状はモノカメラが提供します。「クロソイド曲線」または、車両前方の車線カーブがどの程度湾曲しているかを表す数学的な情報も計算に含まれます。車両前方の認識可能な物体のサイズ、位置、そこからの距離はレーダーセンサーデータ及びカメラデータの解析とのコンビネーションで得られます。コンティネンタルのeHorizonは最終的に、その場で読みとられたデータで、地図の枠組みを提供します。デモンストレーション車ではeHorizonは依然として静的であり、ナビゲーションのデータ資料だけを使っています。コンティネンタルでは、ネットワーク化され、非常に動的なeHorizon製品のシリーズ成熟に取り組んでいます。よって、さまざまな情報源 (車対車、交通コントロールセンターなど) からのデータもAR-HUDでの表示用に編集可能です。デジタルマップ上の車の位置決めは、ドライビングダイナミクスやカメラ、GPSのデータの統合を用いて行われます。

統合されたデータからARクリエイターは、車両前方の幾何学的な道路コースがドライバーの位置からどのように見えるかを算出します。これが可能なのは、ド ライバーの目の位置を把握しているためです。デモンストレーション車ではドライバーが運転を始める前に一度だけ、いわゆるアイボックスの位置を自分に適正 なように設定します。シリーズ生産になれば、このプロセスは内部カメラを使って自動化することができようになります。内部カメラはドライバーの目の位置を 認識し、アイボックスの位置を配置し調整することが可能です。アイボックスとは、高さと幅が理論上「覗き窓」に相当する長方形の領域を示しています。ドラ イバーがこの窓から道路を見る間だけ、完全なAR-HUD画像がとらえられます。車の乗員にはHUDとAR-HUDの表示された内容は見えません。

「設定可能なアイボックスの位置に基づいて、ARクリエイターはドライバーの目がどこにあり、どのような視点から交通状況と環境を見ているかを認識しています。」とギーゲリヒは説明します。アシスタンスシステムが関係の観察結果を報告すると、それに対応する仮想指示がAR-HUDのフォーカシングスクリーン上の適切な位置に生成されます。

少なければ少ないほどより良い

HMI開発者のシュテファン・シーラー(Stephan Cieler) は「仮想指示の設計には多数の開発労力が注ぎ込まれています。数々の設計試作や被験者実験により、私たちのモットーはAR-HUDにおいても、少なければ少ないほどより良いという事になりました。」と述べています。

車線の上に透明なカラーマットを敷くという当初のアイディアは、間もなく変更され、シーラーは「実際の交通ビューが覆われてしまわないよう、ドライバーに与えるグラフィックの指示を必要最小限にするつもりです。」と述べています。

例えばナビゲーション補助の角張った矢印の先は、別の方法として車線上に平らに「置く」可能性や、方向転換の際に標識のようにまっすぐ新しい走行方向へ回転させる可能性もあります。この設計により狭い曲線半径においても、この状況では視点的に可視範囲が足りないため拡張が不可能であっても、仮想指示を出すことが可能です。

車線境界逸脱の場合の警告も目立たなく実装されています。ドライバーが意図せずに境界線を超えてしまった場合、デモンストレーション車のAR-HUDにより、車線が強調されるのみとなります。

将来的にeHorizonが前もって事故情報を受けると、高い注目値の危険シンボルを、早期にドライバーの視界に入れることができるようになります。

リヒタ―は「新しい形式のドライバー対話が一度インストールされると、状況に関係した予告情報をドライバーに与えるため、HMIは多くの可能性を提供します。この対話に言葉がなくとも、車とドライバーは互いに話ができるのです」と述べています。

*本プレスリリースは、現地時間2014年7月21日に、ドイツ・バーベンハウゼンで発表した内容の参考訳です。万が一、英文原文と意味合いが異なる部分がある場合には英文が優先されます。

コンチネンタル・オートモーティブ株式会社ホームページはこちら